Sommaire

- Chapitre 1 : Introduction, Concepts de base

- Chapitre 2 : Architecture d'un ordinateur

- Chapitre 3 : Microprocesseur

- Chapitre 4 : Mémoires

- Chapitre 5 : L'architecture Core 2 et AMD K10

- Chapitre 6 : Optimisation : au coeur du core

- Bibliographie

2. Architecture d'un ordinateur

the understanding in a field where it can not profitably venture,

but that he produces sentences which fail to conform to the conditions

under which alone a sentence can be literally significant.

A. J. Ayer, p 15, Language Truth and Logic, 1936

2.1 Génèse

Les premiers calculateurs, qu'ils fussent mécaniques, électro-mécaniques ou électroniques, ne furent pas l'aboutissement de travaux de recherche, mais résultèrent de la mise en pratique de découvertes scientifiques appliquées à la mécanisation du calcul. Ils furent créés comme des outils annexes aptes à simplifier des tâches humaines plus complexes :

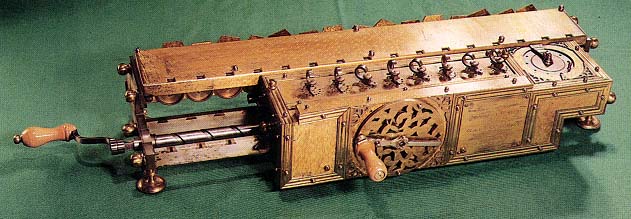

- Pascaline : Pascal construit une machine à calculer pour aider son père, intendant à Rouen et qui devait réaliser de nombreux calculs,

- Mark I : aide à la résolution d'équations différentielles

- ENIAC : aide pour les calculs de ballistique

La Pascaline |

La machine de Leibniz |

Les premières applications des calculateurs automatiques concernaient le calcul numérique. A la fin des années 40, l'ordinateur quitta progressivement les laboratoires ou il était né pour se répandre au sein de l'armée, de l'industrie ou du commerce. On lui assigna alors des tâches différentes de ce pourquoi il avait été créé : traiter automatiquement de gros volumes de données pas forcément numériques.

Cependant, les ordinateurs de l'époque constituaient une denrée rare que seul un petit nombre de privilégiés pouvait approcher. L'ordinateur était une ressource critique : les coûts des machines étaient exorbitants et leurs capacités relativement faibles, il fallait donc les utiliser à bon escient. On conçoit aisément que l'ordinateur n'ait pas été utilisé à ses débuts à des fins ludiques.

On a ensuite compris (à partir de 1950) que ces machines pouvaient devenir tellement complexes et qu'elles disposaient d'un tel potentiel qu'elles pouvaient constituer un domaine d'étude et de recherche à elles seules.

L'informatique était née. Mais avant d'en arriver là, de nombreuses découvertes furent nécessaires.

2.1.1 Les travaux théoriques

a) La logique

Les grecs furent sans doute les premiers dans le monde occidental à tenter de formaliser le raisonnement humain. Ils élaborèrent un cadre formel appelé logique (Organon d'Aristote, Eléments d'Euclide). La logique (logos = discours) est, de manière simplifiée, l'étude de l'adéquation de la pensée avec le discours. Elle tente de modéliser le processus de raisonnement humain de manière simplifiée.

La logique faisait initialement partie de la philosophie. Cependant les mathématiciens ont trouvé dans la logique un formidable outil capable de les aider à formaliser et automatiser leurs raisonnements et ont donc développé une branche de la logique appelée logique mathématique qui traite du raisonnement et plus particulièrement de la démonstration ou de la preuve.

De nombreux travaux ont concouru à l'élaboration de la logique comme nous la connaissons aujourd'hui:

- travaux de Gottfried Wilhelm von Leibniz (1646 - 1716)

- 1847 : Mathematical Analysis of Logic de George Boole (1815 - 1864)

- 1847 : Formal Logic, Morgan

- travaux d'idéographie (Begriffsschrift, 1879) de la logique de Friedrich Ludwig Gottlob Frege (1848 - 1925)

- 1921 : Tractatus logico-philosophicus de Ludwig Wittgenstein (1889 - 1951)

- Les Principia Mathematica (1910, 1912, 1913) d'Alfred Whitehead (1861 - 1947) et Bertrand Russell (1872 - 1970)

- travaux de Alonzo Church, Alan Turing, Kurt Gödel

La fin du XIXème siècle et le début du XXème siècle sont marqués par les difficultés qu'ont les mathématiciens à établir leur discipline sur des fondations solides. C'est ce qu'on a appelé la crise des fondements (Cantor, Berry, Russell).

Les mathématiques ont en effet été considérées jusqu'à la fin du XIXème siècle comme une source d'inspiration divine : elles ne faisaient que refléter le caractère idéalement parfait de Dieu et le mathématicien ne faisait que redécouvrir l'empreinte de Dieu.

En 1900, le mathématicien David Hilbert présenta, lors d'un congrès international qui eut lieu à Paris, 23 problèmes ouverts, et qui selon lui, demandaient une attention toute particulière car leur résolution permettait des avancées majeures en mathématiques. Hilbert posait notamment la question de savoir s'il existait un procédé mécanisable à caractère fini qui premettrait de résoudre toutes les questions mathématiques récalcitrantes.

En 1924 naquit un mouvement initié par Moritz Schlick qui prit les noms successifs de Cercle de Vienne (Wiener Kreis), positivisme logique et Mouvement pour l'Unité des Sciences. Ce mouvement tire ses origines du positivisme scientifique d'Auguste Comte (1798-1857), du logicisme de Frege et des travaux de Hilbert. De nombreux scientifiques et philosophes ont adhérés à ce mouvement qui avait pour but de fonder une nouvelle philosophie de la science en excluant toute considération métaphysique. Pour ce faire, on cherche à exprimer toute proposition (philosophique, mathématique) dans un langage dont seul importe la syntaxe. Ce mouvement cherchait notamment à réduire les mathématiques à la logique.

On considère un alphabet de symboles. On fixe des règles comparables à l'orthographe et à la grammaire pour construire une formule à partir des symboles. On établit ensuite des axiomes (ou prémisses) qui sont des vérités initiales, puis on énonce des règles pour déduire une nouvelle formule à partir d'une formule précédente ou d'un axiome. Les mathématiques sont remplacées par un ensemble de formules. Une démonstration consiste en une manipulation de symboles selon des règles bien définies et se présente comme une suite logique d'application de règles.

Ce procédé vise donc à soustraire la sémantique liée à la compréhension d'un problème. On pourra lire à ce sujet "Le Mirroir Automate" de Gérard Chazal.

Cependant les travaux de Gödel en 1931 notamment ses théorèmes d'incomplétude montrèrent que c'était impossible. Dans "Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme (Sur l'indécidabilité formelle des "Principia Mathematica" et des systèmes apparentés), Gödel démontre que pour n'importe quel système axiomatique indépendant suffisamment puissant pour décrire l'arithmétique des entiers, il existe des théorèmes ne pouvant être ni infirmés ni confirmés. Cette démonstration mit à mal les espoirs du Cercle de Vienne.

S'il existait un système mécanique capable de démontrer des théorèmes en mathématiques, alors on pourraît démontrer "simplement" :

- la conjecture de Goldbach (tout nombre entier naturel pair est la somme de deux nombres premiers), problème toujours ouvert

- ou le grand théorème de Fermat ( xn + yn = zn ) ne possède pas de solution entière pour n > 2, (démontré par Andrew Wiles en 1993).

b) Calculabilité et décidabilité

Comme nous venons de le voir, modéliser la pensée humaine et son mode de fonctionnement, tenter de l'automatiser, sont des tâches ardues et nous sommes encore loin de parvenir à des résultats nous approchant d'une intelligence artificielle substancielle.

Cependant, il est un domaine de la pensée humaine que l'on peut facilement automatiser, c'est celui du calcul. Depuis des siècles, de nombreux scientifiques s'évertuent à créer des machines aptes à réaliser des calculs de manière automatique. Schikard, Pascal, Leibniz, Babbage, pour ne citer qu'eux, ont réalisé des "machines à calculer" mécaniques (formées de bois et de métal) de plus en plus complexes.

Notamment Charles Babbage (1791-1871) avec ses deux inventions que sont la machine différentielle (1821), puis la machine analytique (qui ne fut pas terminée de son vivant) démontre la possibilité de "programmer" un calculateur avec des cartes perforées (punch card en anglais).

Les résultats obtenus par Gödel n'ont pas mis un terme aux recherches entamées dans le cadre de la mécanisation du calcul. Plusieurs chercheurs ont alors tenté de définir formellement la notion de calculabilité : c'est à dire, comment caractériser ce qu'est une fonction calculable.

Définition : Calculabilité

Une fonction est dite calculable s'il existe une procédure algorithmique finie permettant de calculer en un nombre fini d'étapes, sa valeur pour tout argument de son domaine (cf [ALL 1994]).

Deux mathématiciens y sont parvenus en utilisant des théories différentes :

- Church en 1936, s'appuyant sur les travaux de Kleene définit le λ-calcul ainsi que les fonctions λ-calculables,

- Turing avec ses automates universels qui prendront le nom de machine de Turing, exposés dans On computable numbers with an application to the Entscheidungs Problem, 1936

Définition : Church - Turing

Toute fonction dite calculable peut être calculée à l'aide d'une machine de Turing.

La notion de calculabilité est liée au 10ème problème de Hilbert :

Etant donnée une équation avec un nombre quelconque de quantités inconnues et avec des coefficients qui sont des nombres entiers rationnels : Trouver un procédé qui peut déterminer par un nombre fini d'opérations, si l'équation est soluble dans les entiers rationnels. Youri Matiyasévitch a démontré en 1970 qu'il n'est pas possible de trouver un tel algorithme pour un polynome de degré supérieur à 5.

Une notion voisine de la calculabilité est la décidabilité qui caractérise les problèmes dont la réponse est oui ou non.

Définition : Décidabilité (ALL 1994)

Une classe de questions est dite décidable s'il existe une procédure algorithmique finie permettant de résoudre toute question de cette classe en un nombre fini d'étapes.

2.1.2 Avancées en physique

De nombreuses découvertes ont également contribué à la réalisation et l'amélioration des ordinateurs :

- Le relai électromécanique qui est un circuit doté d'un électro-aimant agissant comme un interrupteur sous l'action d'un autre courant

- Le tube à vide que l'on peut également utiliser comme interrupteur

- Le transistor, c'est un relai ou une tube à vide implanté sur une plaquette de silicium.

2.1.3 Le Z3 - premier calculateur "moderne"

Konrad Zuse (1910 - 1995) réalisa le Z1, Z2 et enfin le Z3 en 1941 pour une usine d'aéronautique de l'armée allemande (le Z3 fut détruit en 1944 par les alliés). Il s'agit du premier ordinateur programmable utilisant le binaire.

- 600 relais pour l'UAL, 1600 pour la mémoire

- addition en 0.7 seconde, multiplication et division en 3 secondes

- mots de 22 bits, nombre flottant

- consommation électrique : 4kW

- poids : 1 tonne

Il semble que le Z3 était un ordinateur très en avance sur ses concurrents directs que furent le Mark I et l'ENIAC.

2.1.4 Le Colossus britannique

Durant la seconde guerre mondiale, les allemands utilisaient la machine Enigma pour coder leurs messages. L'un des buts fixés à l'Intelligence Service fut de casser les codes Enigma.

La conception de Colossus commença en mars 1943 à Bletchley Park sous l'égide de Max Newman et de son équipe. Le Colossus fut opérationnel en janvier 1944 et permit de décoder en quelques heures les messages codés allemands.

Les anglais gardèrent secret leur machine. Ce n'est qu'en 1970 que l'on apprit l'existence de Colossus

2.1.5 Le Mark I

L'un des tous premiers ordinateurs américain est l'IBM ASCC (Automatic Sequence Controlled Calculator) créé par Howard H. Aiken. Ce calculateur fut vendu à l'université de Harvard qui le baptisa Mark I.

Ses caractéristiques étaient les suivantes :

- 16 m de long, 2,4 m de haut, 60 cm de largeur

- poids : 4,5 tonnes

- 765.000 composant et des centaines de kms de câbles

- mémoire de 72 nombres composés de 23 chiffres décimaux

- 3 additions ou soustractions par seconde

- 1 multiplication toutes les 6 secondes

- 1 division toutes les 15 secondes

- logarithme et fonctions trigonométriques : 1 minute

Le Mark I était une machine autonome capable de lire ses instructions sur des cartes perforées mais ne pouvait effectuer d'instruction de branchement conditionnel (if).

2.1.6 L'ENIAC

l'ENIAC (Electronic Numerical Integrator and Computer) fut terminé en 1946. Il a été construit à l'Université de Pennsylvanie par John Mauchly et John Eckert à partir de 1943 pour les besoins du BRL (Ballistics Research Laboratory).

Le BRL était une agence de l'armée américaine chargée d'élaborer les tables de portée et de trajectoire des projectiles. Ce travail occupait près de 200 personnes qui utilisaient des "machines à calculer" de l'époque pour établir l'ensemble des caractéristiques des projectiles, données sans lesquelles ces armes étaient inutilisables par les artilleurs. La préparation des tables pour un projectile pouvait occuper une personne pendant plusieurs dizaines d'heures voire plusieurs jours.

Mauchly alors professeur d'ingénierie électrique à U Penn, assisté de son thésard Eckert, proposa de construire un ordinateur pour répondre aux besoins du BRL.

Les caractéristiques de l'ENIAC étaient les suivantes :

- il pesait 30 tonnes

- utilisait 19000 tubes à vides

- possédait 20 "registres" capables de stocker des nombres décimaux sur 10 chiffres

- il était capable d'effectuer une multiplication de deux nombres en 1 seconde, ce qui constituait une avancée majeure par rapport aux calculateurs mécaniques 500 fois plus lent.

L'ENIAC qui fut terminé en 1946 ne participa pas à l'effort de guerre mais fut utilisé dans l'élaboration de la bombe H. L'ENIAC fonctionna jusqu'en 1955 au BRL.

Une caractéristique préjudiciable de l'ENIAC était que la programmation s'effectuait par cablage :

2.1.7 Von Neumann et l'EDVAC

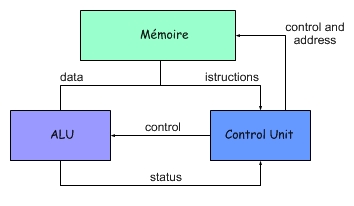

L'architecture des ordinateurs actuels repose sur le modèle de Von Neumann. John Von Neumann (1903-1957) était un mathématicien américain d'origine hongroise. Il travailla comme consultant dans le projet ENIAC puis participa à la création de la première bombe atomique à Los Alamos. Il entrevit le potentiel des machines électroniques dans le calcul à grande échelle.

Von Neumann eut l'idée (que d'autres eurent probablement avant lui) que la mémoire de l'ordinateur ne devait pas servir qu'à stocker uniquement des données, mais elle devait également stocker les programmes : c'est le concept de programme enregistré.

Dans son article fondateur intitulé First draft of a report on the EDVAC (30 Juin, 1945, Université de Pennsylvanie), il décrit également l'organisation qui devrait être celle d'un ordinateur moderne :

- une mémoire

- une unité de calculs CA (Central Arithmetical part) que nous appelons de nos jours ALU (Arithmetic and Logic Unit)

- une unité de contrôle CC (Central Control device)

La mémoire stocke des nombres (Standard numbers) et des instructions (Orders) sur 32 bits. Le bit 31 vaut 0 s'il s'agit d'un nombre et 1 dans le cas d'une instruction.

Architecture de Von Neumann

(voir le site suivant)

En raison de conflits qui l'opposèrent à Eckert et Mauchly, Von Neumann rencontra quelques problèmes dans la création d'un nouvel ordinateur basé sur l'EDVAC. En effet, lorsque Von Neumann publia son First Draft, il ne fit apparaître que son seul nom sur l'article. Eckert et Mauchly considéraient que si Von Neumann avait pu en arriver la, c'était en raison de leur collaboration et de leurs discussions. Néanmoins, Von Neumann construisit à Princeton un ordinateur baptisé IAS entre 1946 et 1952 qui était basé sur le modèle de l'EDVAC.

L'architecture de Von Neumann s'oppose à celle dite de Harvard (Mark I).

Avec une architecture de type Harvard, les données et les instructions sont stockées dans des mémoires différentes et utilisent des bus différents. Cela rend les ordinateurs de type Harvard plus rapides car ils sont capables de lire en même temps une instruction et une donnée, alors qu'avec une architecture de type Von Neumann, on peut soit lire une instruction, soit lire/écrire une donnée.

Pour info : les DSP (Digital Signal Processors) ou Processeurs de Signal Numérique sont des circuits électroniques spécialisés dans les calculs complexes et reposent sur une architecture de type Harvard. Ils sont notamment utilisés pour le traitement des données audio et vidéo.

Voici un exemple d'une architecture de harvard

2.1.8 L'UNIVAC

Eckert et Mauchly créérent leur propre société en 1947 pour fabriquer et commercialiser des ordinateurs. Leur premier succès fut l'UNIVAC I (UNIVersal Automatic Computer) dont le premier modèle fut livré en mars 1951 au Bureau du Recensement américain.

Les prix exorbitants des premiers ordinateurs les mettaient hors de portée de la plupart des grandes entreprises et des universités. L'UNIVAC atteignit des prix avoisinant les \$1.250.000 et \$1.500.000.

L'UNIVAC fut utilisé par :

- le Bureau du Recensement

- la Commission de l'Energie Atomique

- l'US Air Force

- la Prudential Insurance Company

- General Electric, pour établir des feuilles de paye

- certaines machines furent offertes aux universités de Harvard et de Pennsylvanie

La commercialisation de l'UNIVAC marque le début de l'industrie informatique.

Pour de plus amples informations sur les premiers calculateurs vous pouvez vous rendre sur la page suivante.

2.2 Les générations suivantes

On classe les ordinateurs suivant la génération technologique à laquelle ils appartiennent :

- première génération : il s'agit des ordinateurs utilisant des tubes à vide,

- deuxième génération : ordinateurs utilisant des transistors au lieu de tubes à vide,

- troisième génération : utilisation de circuits intégrés

- quatrième génération : utilisation de microprocesseurs

Durant la deuxième génération a vu la naissance des mini-ordinateurs, c'est à dire des ordinateurs moins volumineux et plus abordables d'un point de vue pécunier. L'utilisation des circuits intégrés a ensuite permis de réduire encore plus la taille des ordinateurs.

| Machine | Année | Coût en k$ | Volume |

| PDP-8 | 1965 | 16,2 | 2,44 |

| PDP-8/L | 1968 | 7 | 0,61 |

| PDP-8/A | 1975 | 2,6 | 0,37 |

La quatrième génération correspond à l'apparition des micro-ordinateurs ce qui a permis la démocratisation de l'informatique.

2.3 Architecture des ordinateurs actuels

Depuis les années 1940, les ordinateurs ont subi de nombreuses évolutions.

La plus importante fut sans doute l'invention du transistor (Bell Labs), suivie par celle du circuit intégré, puis par l'invention du microprocesseur par Intel en 1971 (cf. Chapitre 3).

Du côté des mémoires, on distingue aujourd'hui la mémoire dite centrale (RAM) de la mémoire de masse (qui correspond aux périphériques tels que les disques durs, ou les "vieilles" bandes magnétiques).

2.3.1 Le boîtier

Le boîtier qui regroupe l'ensemble des composants, également appelé Unité Centrale est aujourd'hui un élément important en raison de plusieurs facteurs :

- calorimétrique : les composants électroniques dégagent de la chaleur et celle-ci doit être évacuée sinon on risque une surchauffe qui pourra engendrer des dégâts

- isolation phonique : certains composants comme les disques durs, les ventilateurs (processeur, carte graphique, alimentation) font beaucoup de bruit, une bonne isolation phonique apporte un certain confort.

- esthétique : le boîtier est devenu un élément de mode ou de standing, de nombreux fabricants proposent des boîtiers au look ravageur. Le tuning PC est aussi bien développé actuellement.

Il existe différentes catégories de boîtiers (cf site suivant):

- de bureau (desktop)

- mini, moyenne ou grande tour

- de salon : pour les systèmes multimédia

- pour serveurs : grandes tours avec alimentation redondante

- pour mini PC : barebones

Exemple : Antec Sonata III

|

|

2.3.2 La carte mère

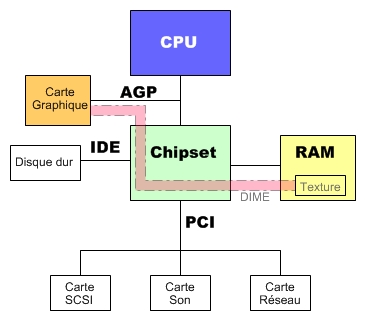

Comme le montre le schéma de l'architecture de Von Neumann, on doit organiser la communication entre trois éléments principaux que sont :

- le processeur

- la mémoire

- les entrées / sorties (périphériques)

L'interconnexion des différents composants et périphériques est réalisée de nos jours grâce à la carte mère.

Carte mère AsRock 775Twins-HDTV (Vue détaillée)

Définition : carte mère

La carte mère est un circuit imprimé qui permet de mettre en contact physique les différents composants et périphériques. Elle représente une sorte d'ossature sur laquelle viennent se connecter (greffer) les composants.

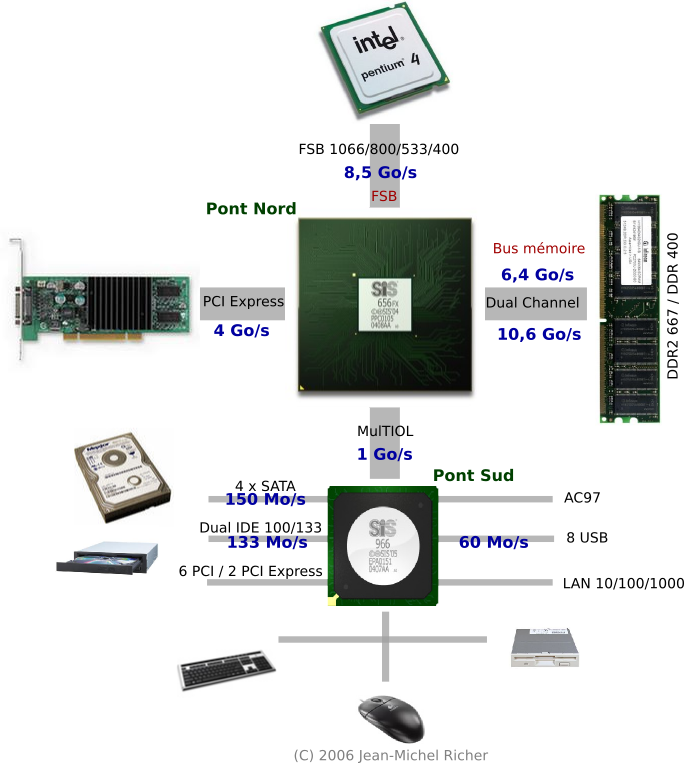

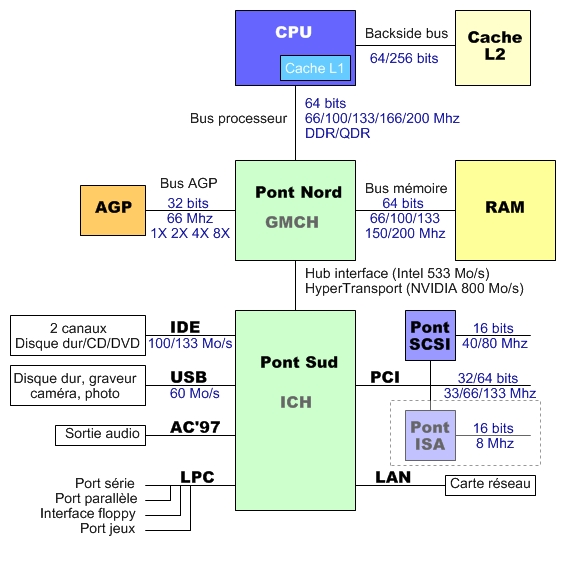

Les cartes mères actuelles (2006) se décomposent en 2 parties :

le pont nord (encore appelé northbridge ou GMCH pour Graphics and Memory Controller Hub) chargé de gérer les composants qui ont besoin d'une bande passante importante :

|

|

le pont sud (appelé southbride ou ICH pour Input/Output Controller Hub) chargé de gérer les périphériques qui ont besoin d'une faible bande passante :

|

|

Vue schématique d'une carte mère de type Intel (2006)

avec chipset Sis 656fx/966,

Vue schématique d'une carte mère de type Intel (2004)

a) Chipset

L'un des éléments principaux de la carte mère est le chipset : c'est un circuit électronique qui contrôle et régule les échanges de données entre les divers composants de la carte mère.

La carte mère et le chipset déterminent :

- la vitesse des différents bus

- le type de processeur qui peut être utilisé et la gamme de fréquences

- le type de mémoire qui peut être utilisé, ainsi que la taille maximale de la mémoire

- les périphériques qui sont susceptibles d'être connectés

Par exemple, les chipset utilisés pour la carte mère AsRock 775 Twins-HDTV sont les suivants :

- north bridge : ATI Radeon XPress 200

- south bridge : ULi 1573

|

|

Exemples de chipsets Intel.

b) Notion de bus

Dans l'architecture de Von Neumann les différents composants dialoguent (ou échangent de l'information) au travers de canaux de communications appelés bus.

Un bus se décompose en 3 parties :

- le bus d'adresses qui permet de spécifier à quelle adresse mémoire on désire accéder :

Largeur de Bus Mémoire adressable Exemple de CPU 16 bits 64 ko Intel 8080 20 bits 1 Mo Intel 8086 24 bits 16 Mo Intel 80286, 80386 SX 32 bits 4 Go Intel 80386 DX, 80486, Pentium 36 bits 64 Go Intel Pentium Pro, P II, P III, P4

Largeur du bus d'adresse et adressage mémoire

- le bus de données qui permet de spécifier d'envoyer ou de recevoir une donnée :

Largeur de Bus Exemple de CPU 4 bits Intel 4004 8 bits Intel 8080 16 bits Intel 8086 32 bits Intel 80386 DX, 80486, 64 bits Intel Pentium et suivants

Largeur du bus de données

- le bus de commandes qui permet de spécifier si on effectue une lecture ou une écriture.

- son type : paralèlle ou série

- sa largeur, exprimée en nombre de bits ou d'octets : il s'agit du nombre de bits qui sont transférés en même temps

- sa fréquence, exprimée en hertz : elle indique la vitesse de transfert de l'information

En fonction de la fréquence et de la largeur, on peut déterminer la bande passante ou débit qui s'exprime en Mo/s ou Go/s (ou Mbits/s, Gbits/s) :

Plus la bande passante est importante, plus le bus est performant.

On distingue deux bus importants au niveau du Pont Nord :

- le FSB (Front Side Bus) qui relie le Pont Nord au processeur

- le bus mémoire qui relie le Pont Nord à la mémoire

Remarque : on notera, concernant les Athlon 64, que le bus mémoire est directement connecté au processeur et ne passe donc pas par le Pont Nord. Cette technique a pour bus d'améliorer la vitesse d'accès à la mémoire.

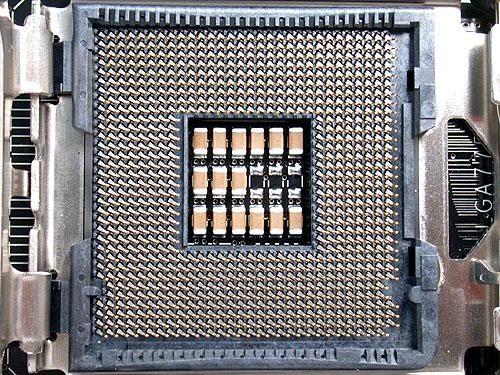

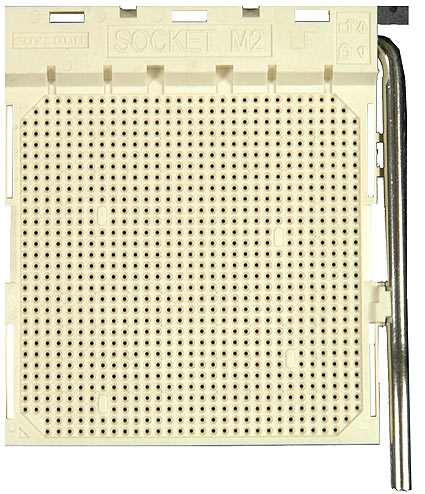

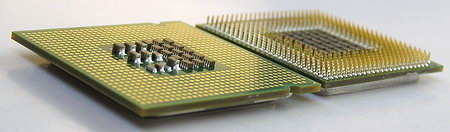

c) Le socket

Définition : Socket

Support pour circuit intégré et notamment pour le microprocesseur qui permet de le relier électriquement à la carte mère sans le souder.

Exemples de sockets actuels :

|

|

2.3.3 les principaux ports et interfaces

On pourra consulter la page suivante concernant les bus plus anciens.

a) L'interface PCI (Peripheral Component Interconnect)

Le bus PCI (Peripheral Component Interconnect) est une norme mise au point par Intel en 1991 et commercialisée à partir de 1992 qui reprend le concept de Local Bus. A l'origine le PCI est un bus de 32 bits fonctionnant à 33 Mhz, soit une bande passante de l'ordre de 132 Mo/s.

Il est également Plug and Play (PnP), ce qui signifie que la configuration d'une nouvelle carte est effectuée directement par le BIOS et le système d'exploitation.

Le bus PCI supporte le DMA (Direct Memory Access) qui permet à un périphérique de prendre le contrôle du bus pour transférer des données directement en mémoire.

L'inconvénient du VL-bus est qu'il force le processeur à suspendre son activité dès lors qu'il transfère des données. LE bus PCI remédie à ce problème : lorsque le processeur envoie des données à un périphérique, celles-ci sont stockées dans une mémoire tampon du contrôleur PCI, puis acheminées ensuite vers le périphérique.

| Révision | 2.0 | 2.1 | 2.2 | PCI-X |

| Année | 1993 | 1995 | 1998 | 1999 |

| Largeur (bits) | 32 | 32 | 64 | 64 |

| Fréquence (Mhz) | 33 | 66 | 66 | 133 |

| Bande passante (Mo/s) | 132 | 264 | 528 | 1064 |

Note : Il existe également la norme PCI 2.3 (Février 2002) qui normalement est un PCI 2.2 permettant d'utiliser une tension de 3,3 V ou de 5 V.

La version 3.0 du PCI ne permet d'utiliser que des cartes fonctionnant sous 3,3 V.

| Norme | Fréquence (Mhz) |

Largeur (bits) |

BP (Mo/s) |

| PCI 2.3 | 32 | 33 | 133 |

| PCI 2.3 | 32 | 66 | 266 |

| PCI 64 | 64 | 33 | 266 |

| PCI 64 | 64 | 66 | 532 |

| PCI-X 1.0 | 64 | 66 | 532 |

| PCI-X 1.0 | 64 | 100 | 800 |

| PCI-X 1.0 | 64 | 133 | 1066 |

| PCI-X 2.0 (DDR) | 64 | 133 | 2132 |

| PCI-X 2.0 (QDR) | 64 | 133 | 4264 |

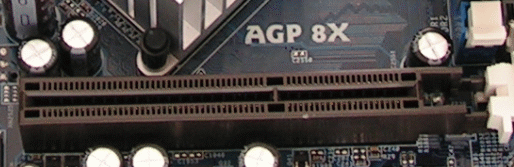

b) L'AGP (Accelerated Graphics Port)

L'arrivée des cartes graphiques 3D très gourmandes en bande passante a posé un nouveau problème au bus PCI. En outre ces cartes ont besoin d'entreposer des données relatives à des textures en mémoire centrale.

Le bus AGP a donc été créé en 1997 pour répondre aux besoins des cartes 3D. Il repose sur une spécification initiale de type PCI 2.1 offrant une bande passante de 264 Mo/s (32 bits à 66 Mhz).

L'AGP est apparu avec les Pentium II et devait répondre à deux attentes :

- libérer le bus PCI du travail engendré par le transfert des données graphiques,

- augmenter la bande passante du sous-système vidéo.

Il intègre les techonologies DMA et DIME :

- DMA (Direct Memory Access) (vu précedemment)

- DIME (Direct Memory Execution) : permet d'effectuer des calculs de texture directement en mémoire centrale avant de les charger dans la mémoire vidéo.

| Révision | AGP 1X | AGP 2X | AGP 4X | AGP 8X |

| Année | 1997 | ? | ? | ? |

| Largeur (bits) | 32 | 32 | 32 | 32 |

| Fréquence (Mhz) | 66 | 66x2 | 66x4 | 66x8 |

| Bande passante (Mo/s) | 264 | 528 | 1056 | 2112 |

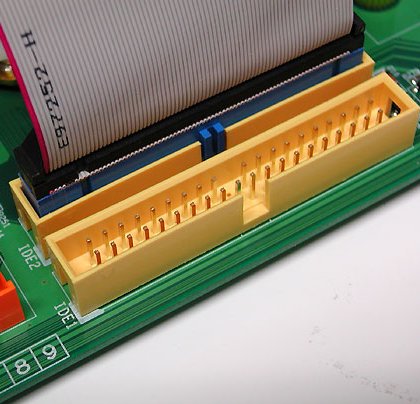

c) L'interface IDE (ou PATA)

L'interface IDE (Integrated Device Electronics), encore appelée PATA pour Parallel Advanced technology Attachment, permet de connecter des périphériphes internes tels disques durs ou lecteurs/graveurs CD/DVD.

Cette interface est limitée à 2 connecteurs qui accueillent chacun un maximum de deux périphériques : l'un en maître, l'autre en esclave. La longueur maximum de chaque cable est de 46 cm.

L'interface IDE existe sous différents protocoles :

- PIO (Programmed Input/output) 3, 4

- Ultra ATA 33/66/100/133

On peut noter que les lecteurs/graveurs de CD/DVD utilisent l'interface ATAPI (ATA Packet Interface) qui est une normalisation de la norme ATA pour les CD/DVD.

| Révision | PIO 3 | PIO 4 | Ultra DMA ATA 33 |

Ultra DMA ATA 66 |

Ultra DMA ATA 100 |

Ultra DMA ATA 133 |

| Apparition | 1993 | 1994 | 1997 | 1999 | 2000 | 2001 |

| Bande passante(Mo/s) | 13,3 | 16,6 | 33 | 66 | 100 | 133 |

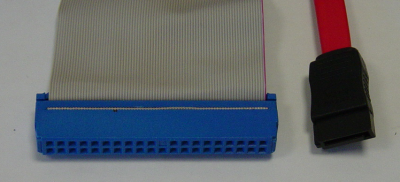

d) L'interface SATA

Le bus SATA vise à remplacer le bus IDE (PATA) en apportant deux améliorations :

- d'une part, la vitesse est acrrue par rapport à l'IDE

- d'autre part, la connectique est simplifiée avec un câble d'au maximum 1 mètre de long et 6 à 8 fils (contre 45 cm pour l'IDE)

La connectique est donc moins volumineuse.

Connectique IDE et SATA

| Révision | SATA 1 | SATA 2 | SATA 3 |

| Apparition | 2002 | 2005 | Mai 2009 |

| Vitess de transfert (Mo/s) |

150 | 300 | 600 |

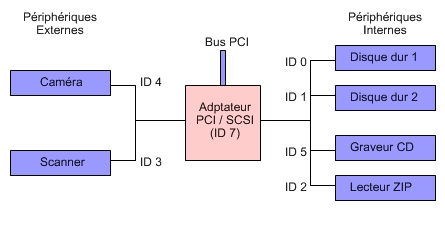

e) L'interface SCSI

L'interface SCSI a été crée en 1986. Dans sa version SCSI 1, elle était composée d'un bus de 8 bits fonctionnant à 4 Mhz, soit une bande passante de 4 Mo/s. Elle a par la suite été améliorée en 1994 (SCSI-2), puis SCSI-3 pour atteindre 320 Mo/s.

L'intérêt de l'interface SCSI est triple :

- d'une part, elle permet de connecter plus de périphériques que l'interface IDE (7 ou 15 suivant la norme alors que l'IDE ne permet de connecter que 4 périphériques),

- d'autre part sa bande passante est supérieure

- plusieurs périphériques peuvent dialoguer en même temps (contrairement à l'IDE)

Son principal défaut est son prix. L'interface SCSI est fiable et chère, elle est donc réservée à des machines haut de gamme de type serveur.

En outre les disques durs SCSI sont relativement chers. Cela est dû en partie à la vitesse de rotation des disques SCSI qui est de 10000 à 15000 tr/min, alors que celle des disques IDE est de 7200 tr/min. Pour information en juillet 2006 (Prix Rue du commerce):

- disque dur SCSI Seagate Ultra 320, 36.7 Go, 10000 tr/min : 180 Euros

- disque dur IDE Hitachi, ATA 100, 80 Go, 7200 tr/min : 44 Euros

- disque dur SCSI Fujitsu Ultra 320, 300 Go, 10000 tr/min : 864 Euros

- disque dur IDE Diamond Max, ATA 133, 300 Go, 7200 tr/min : 95 Euros

- disque dur SATA, Western Digital, SATA 1, 300 Go, 7200 tr/min : 112 Euros

- disque dur SATA, Seagate, SATA 1, 750 Go, 7200 tr/min : 446 Euros

Organisation du Bus SCSI

| Version | SCSI 1 | SCSI 2 | SCSI 2 | SCSI 3 | SCSI 3 | SCSI 3 | SCSI 3 |

| Dénomination | SCSI | Fast | Wide | Ultra | Ultra 3 | Ultra 160 | Ultra 320 |

| Larbeur (bits) | 8 | 8 | 16 | 8 | 8 | 16 | 16 |

| Fréquence (Mhz) | 4,77 | 10 | 10 | 20 | 80 | 80 | 80 DDR |

| Bande passante (Mo/s) | 5 | 10 | 20 | 20 | 80 | 160 | 320 |

| Maximum de Périphériques |

7 | 7 | 15 | 7 | 15 | 15 | 15 |

Liens sur le SCSI :

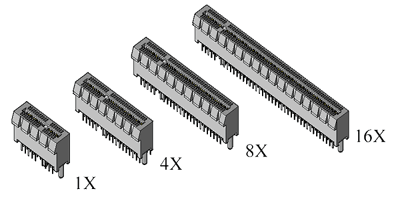

f) Le PCI-Express

Le nouveau bus PCI Express vise à remplacer les bus PCI et AGP. Il s'agit d'un bus série qui est au PCI ce que le Sérial ATA est au Parallel ATA. On dispose donc d'une version dite 1X consistant en une seule ligne d'un bit bidirectionnelle fonctionnant en point à point. On peut ensuite combiner plusieurs lignes.

| Type de bus | Largeur | Fréquence | B.P. | Broches |

| PCI | 32 bits | 33 Mhz | 133 Mo/s | 49 |

| PCI | 64 bits | 66 Mhz | 533 Mo/s | 102 |

| PCI-X | 64 bits | 100 Mhz | 800 Mo/s | 102 |

| PCI-X | 64 bits | 133 Mhz | 1 Go/s | 102 |

| PCI Express 1X | 1 bit | 2,5 Ghz | 500 Mo/s | 8 |

| PCI Express 2X | 2 bits | 2,5 Ghz | 1000 Mo/s | ? |

| PCI Express 4X | 4 bits | 2,5 Ghz | 2 Go/s | 20 |

| PCI Express 8X | 8 bits | 2,5 Ghz | 4 Go/s | 40 |

| PCI Express 16X | 16 bits | 2,5 Ghz | 8 Go/s | 80 |

Le calcul de la bande passante d'un bus PCI Express nous permet de nous livrer à des calculs savants. Par exemple pour le PCI Express 16X :

- bande passante unidirectionnelle : (16/8) octets * 2,5 Ghz = 5 Go/s

- le bus PCI Express étant bidirectionnel on a donc : 2 x 5 Go/s = 10 Go/s

- reste à retirer 20% du résultat précédent qui correspond aux informations inutiles utilisées dans les entêtes de trames : 0,8 x 10 Go/s = 8 Go/s

La version 16X est dédiée aux cartes graphiques. Les avantages par rapport à l'AGP sont les suivants :

- on dispose d'une bande passante de 4 Go/s dans le sens carte graphique vers processeur,

- on dispose d'une bande passante de 4 Go/s dans le sens processeur vers carte graphique,

- la ou l'AGP n'autorise qu'une bande passante de 2 Go/s dans un seul sens

g) Bus USB (Universal Serial Bus

La spécification USB a été publiée en 1996. Plusieurs sociétés dont Compaq, Intel, IBM, Microsoft, NEC se sont regroupées afin de définir une nouvelle interface destinée à remplacer et unifier les différentes connexions bas débit : clavier, souris, imprimante...

L'USB est donc un bus série externe.

Dans sa version 1.0, l'USB possède une bande passante de 12 Mbits/s (1,5 Mo/s) ce qui est suffisant pour les périphériques cités précédemment. Il permet de connecter jusqu'à 127 périphériques.

La norme USB 2.0 (2001) permet d'atteindre 480 Mbits/s soit 60 Mo/s. On a donc vu l'apparition d'autres périphériques dotés d'une interface USB (Lecteurs ZIP, disques durs externes, graveurs CD/DVD externes, scanner).

La norme USB 3.0 (2009-10) est rétro-compatible avec l’USB 2.0, avec un débit théorique de 4.8 Gb/s soit 600 Mo/s (400 Mo/s observés), l’USB 3.0 baptisé Superspeed devrait arriver courant Janvier 2010.

Le bus USB est destiné à remplacer les bus série/parallèle. Il possède l'avantage de supporter le mode Hot Plug and Play permettant de brancher et débrancher les périphériques lorsque l'ordinateur est en fonctionnement.

| Norme | Dénomination | Vitesse (Mo/s) | Longueur câble |

|---|---|---|---|

| 1.0 | Low Speed | 0,2 | 5 m |

| 1.1 | Full Speed | 1,5 | 5 m |

| USB 2.0 | High Speed | 60 | 5 m |

| USB 3.0 | SuperSpeed | 600 | 3 m |

h) Bus FireWire (IEEE 1394)

Le bus FireWire (Apple) ou iLink (Sony) ou IEEE 1394 a été mis au point par Apple en 1995. Il s'agit d'un bus à haut débit ressemblant à l'USB et permetant de connecter jusqu'à 63 périphériques.

Il a été conçu principalement pour les périphériques multimedia à haut débit : caméras, camescopes, synthétiseurs audio, scanners et imprimantes professionnelles.

Initialement doté d'une bande passante de 50 Mo/s (400 Mbits/s), une révision (IEEE 1394b) a permis d'atteindre 100 Mo/s (800 Mbits/s).

La norme 1394b ou FireWire 800 a été introduite à partir de 2003 mais ne devrait être adoptée qu'à la fin 2008, elle autorise un débit de 3200 Mbits/s, soit 400 Mo/s

i) Wifi et Bluetooth

A la base, la communication sans fil était destinée à la connexion des périphériques (clavier, souris,...) afin d'éviter l'enchevêtrement de fils ce qui n'est pas toujours esthétique. C'est dans cette optique que le protocole BlueTooth a été développé par la société Ericsson. Il utilise une bande de fréquence de 2,4 Ghz offrant un débit de 721 kbits/s) pour une portée d'une dizaine de mètres.

Il est cependant apparu à ceux qui se sont frottés à la technologie sans fil que l'on pouvait utiliser également les ondes radio afin de faire communiquer non pas seulement des périphériques avec une unité centrale, mais également de faire communiquer des ordinateurs entre eux. On parle alors de Wireless Fidelity Network ou Wi-Fi

L'année 2002 a vu l'arrivée de la norme 802.11b permettant la connexion de réseaux sans fils. IEEE 802.11b ou WiFi (Wireless Fidelity) est une technologie de réseau local sans fil WLAN (Wireless LAN).

La norme 802.11 regroupe de nombreuses normes, dont en particulier :

- 802.11.b : communication sur 2,4 Ghz avec une bande passante de 11 Mbits/s

- 802.11.a : communication sur 5 Ghz avec une bande passante de 54 Mbits/s

- 802.11.g : évolution du 802.11.b pour le porter à 54 Mbits/s

- 802.11.n : évolution du 802.11.g pour le porter à 600 Mbits/s (fin 2008)

L'intérêt de la technologie sans fil est la possibilité de créer un PAN (Personal Area Network) ou réseau de machines, que ce soit dans le cadre d'une entreprise ou à la maison. Il est alors possible de partager une imprimante ou une connexion à internet, d'échanger de gros fichiers, de jouer à plusieurs.

WiFi  |

BlueTooth  |

|

| Bande de fréquence | 2,4 Ghz | 2,4 Ghz |

| Débit (bande passante) | 11, 54 Mbits/s | 1 Mbits/s |

| Portée | 100 m | 10 m |

| Avantages | BP importante | faible consommation facile à utiliser moins cher |

En savoir plus : lien PPC/Tomshardware

Exercices

Exercices d'entraînement

Exercice 1 : calculer la bande passante des bus suivants :

- Front Side Bus d'un Pentium 4 de vitesse nominale 200 Mhz

- Front Side Bus d'un Pentium 4 de vitesse nominale 266 Mhz

- Front Side Bus d'un Ahtlon 64 de vitesse nominale 100 Mhz

Exercice 2 : calculer la bande passante des bus suivants :

- bus AGP 1x

- bus AGP 2x

- bus AGP 4x

- bus AGP 8x

- bus PCI Express 16x

Exercice 3 : classer par ordre croissant des vitesses de transfert les différentes interfaces vues précédemment (penser à utiliser éventuellement un tableur pour simplifier le travail).

Exercice 4 : dresser un tableau comparatif qui pour chaque type de périphérique (disque dur, CD/DVD, imprimante, scanner, ...) indique quelles interfaces sont susceptibles d'être utilisées et quels sont leurs taux de transfert.